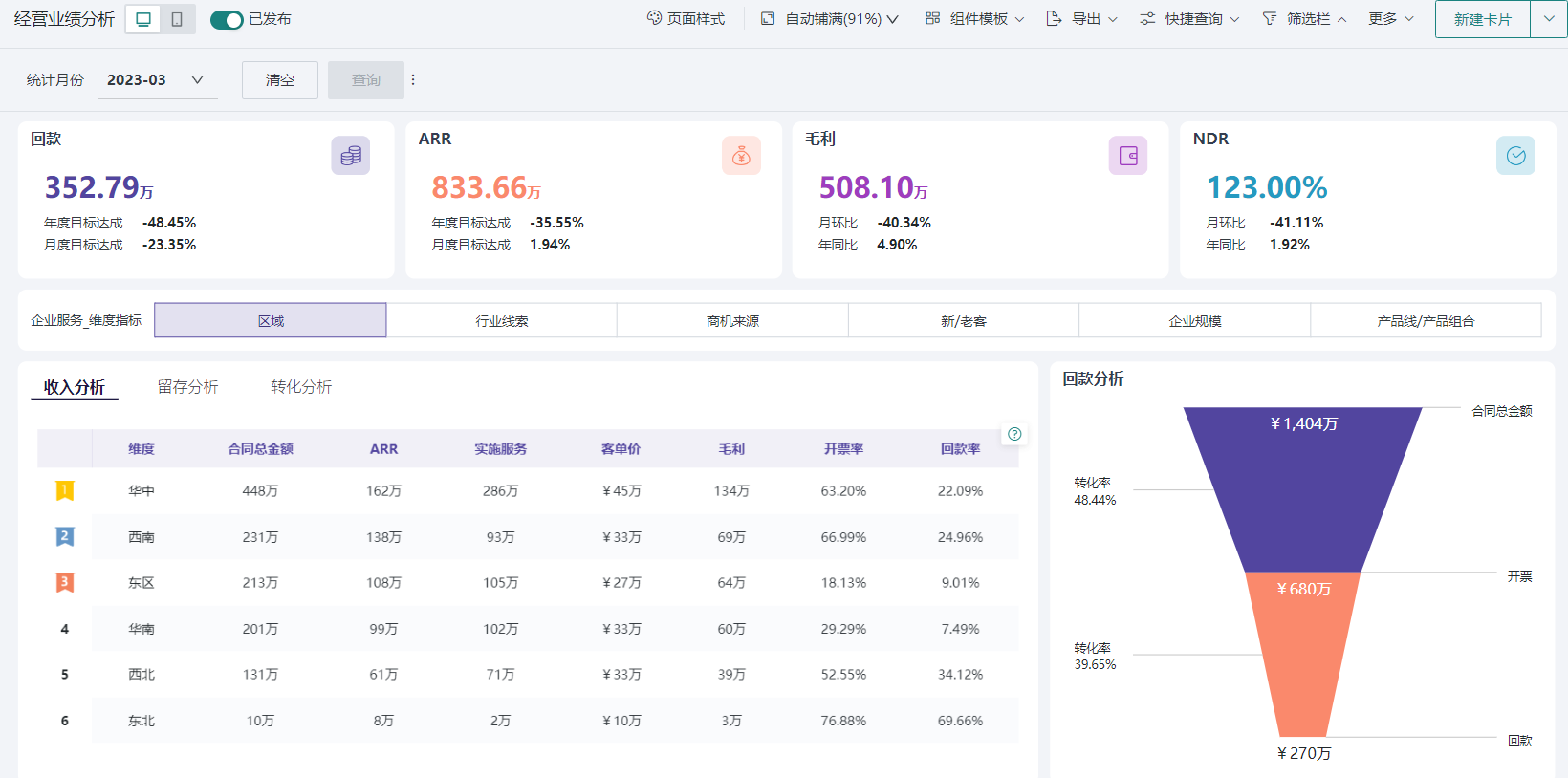

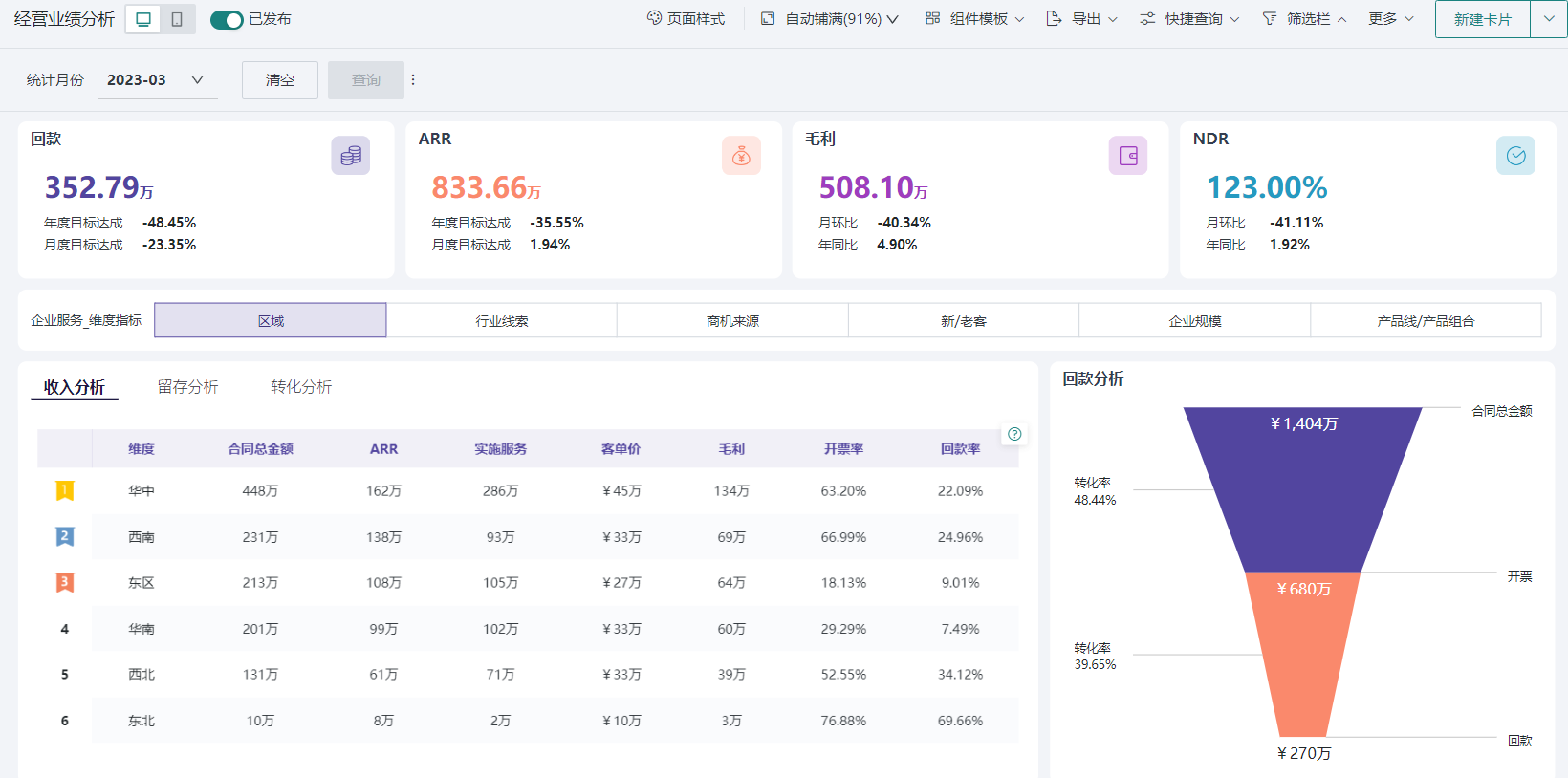

我观察到一个现象,很多企业在投入巨资构建智能风控系统时,目光往往聚焦在软件采购和服务器部署上,以为这就是成本的大头。但实际上,真正的成本失控区,往往潜藏在数据建模的深处。说白了,一个看似基础的“原子指标”,从诞生到应用,其背后连接的可能是一条极其昂贵的成本曲线。很多人在做指标体系设计时,容易陷入技术的细节,却忽略了每一个决策对总体拥有成本(TCO)的深远影响,尤其是在构建复杂的智能风控系统时,这种忽视的代价更高。

一、数据溯源的真实成本曲线有多惊人?

说到数据溯源,很多人反应是技术问题,但从成本效益角度看,这其实是个经济问题。当智能风控系统的模型出现一个异常结果,比如一个高价值客户被错误拒绝,你需要追溯是哪个原子指标出了问题。这个追溯过程的成本,就是一条陡峭的曲线。初期,你可能觉得让几个数据分析师手动排查一下,成本可控。但随着原子指标数量从几十个增长到几千个,数据来源横跨十几个业务系统时,手动溯源的成本会指数级飙升。不仅如此,这个过程极其耗时,当风控决策需要秒级响应时,长达数小时甚至数天的溯源过程带来的业务损失是无法估量的。糟糕的数据来源管理,更是让这个成本雪上加霜。

.png)

换个角度看,缺乏自动化的数据血缘关系管理,还会带来巨大的合规风险成本。特别是在金融行业,监管机构要求对决策依据有清晰的解释,无法快速、准确地追溯一个关键原子指标的来龙去脉,可能意味着高额的罚款。因此,前期在数据治理平台上的投入,看似昂贵,实则是在为未来节省更大规模的排错成本和合规成本。一个完善的数据建模流程,必须将数据溯源的自动化和可视化作为前置条件,否则整个智能风控系统的维护成本将成为一个无底洞。

| 成本维度 | 手动溯源成本(年/预估) | 自动化溯源平台成本(年/预估) |

|---|

| 人力成本(中级分析师) | ¥800,000 (4人) | ¥200,000 (1人维护) |

| 时间成本(机会损失) | ¥500,000+ | ¥50,000 |

| 合规风险(潜在罚款) | 极高 | 低 |

| 总计显性与隐性成本 | ~¥1,300,000+ | ~¥250,000 + 平台年费 |

二、指标设计的维度陷阱如何吞噬预算?

一个常见的痛点是,业务团队在提需求时,希望原子指标的维度越全越好,“未来可能用得上”是他们的口头禅。然而,这种“多多益善”的思维正是成本的陷阱。在指标体系设计中,每增加一个维度,存储成本、计算成本和维护成本都可能呈几何级数增长。例如,一个“用户交易金额”的原子指标,如果增加了“时间(秒级)”、“地点(GPS精度)”、“设备类型”、“商品品类”等多个维度,其产生的数据量会急剧膨胀。这不仅直接推高了数据仓库的账单,更重要的是,复杂的原子指标会让后续的数据建模变得异常困难和低效。模型训练时间加长、计算资源消耗加大,这些都是隐藏的成本。

更深一层看,这就是典型的原子指标应用误区。大家误以为指标原子化就是拆得越细越好,却忘了“恰到好处”才是关键。在智能风控系统的场景下,过于复杂的指标反而可能引入噪音,影响模型准确性,导致风控效果下降,这又是另一种形式的成本。明智的做法是,在定义原子指标时,就进行严格的成本效益评估。思考“如何选择关键原子指标”不仅仅是技术问题,更是业务和财务的综合考量。必须追问每个维度是否真的对提升风控决策有显著价值,能否覆盖其带来的全周期成本。

【成本计算器】

每月新增成本 ≈ (原子指标数 × 平均维度组合数 × 日增数据条数 × 30天) × (存储单价 + 计算单价)

一个拥有500个原子指标、平均5个维度的中型平台,如果每个指标每日新增100万条记录,其每月仅在存储和基础计算上的成本就可能轻松突破数万元,这还不包括更复杂的数据建模与分析任务。

三、质量校验的暗流损耗体现在哪里?

如果说指标设计是“开源”,那么质量校验就是“节流”,但这个“流”往往是看不见的暗流。数据质量监控的缺失或不足,其成本损耗是滞后且致命的。想象一下,一个用于智能风控系统授信模型的原子指标——“用户近3月平均收入”,如果因为数据源ETL脚本的一个bug,导致部分用户该指标值为0,会发生什么?系统可能会拒绝大量本该通过的优质客户,导致直接的业务收入损失;或者,反过来,一个异常的高值可能让高风险用户获得了不匹配的信用额度,形成坏账。这些都是真金白银的损失。

很多人认为数据质量是数据团队的事,但成本却是由业务团队承担。当一个原子指标的数据质量出问题时,定位问题的过程本身就在消耗成本。数据工程师需要排查数据链路,业务分析师需要重新评估模型表现,产品经理需要向用户解释为何服务异常。整个链条上的人力都被卷入,而这些时间本可以用来创造更多价值。一个在北京的独角兽金融科技公司就曾遇到过类似问题,一个核心原子指标的异常波动在两周后才被发现,期间造成的审批流失率上升了近20%,直接经济损失超过百万。说白了,对数据质量监控的投入,本质上是在购买一份“业务稳定性的保险”,这份保险在平时看似无用,但在关键时刻能避免颠覆性的损失。

【误区警示】

一个普遍的误区是“事后补救”。许多团队习惯于在业务端出现问题后,再回头去查数据质量。这种模式的成本极高。正确的做法应该是将数据质量监控(Data Quality Monitoring)嵌入到数据生产的每一个环节,从数据源接入、清洗、加工到原子指标生成,设立关键校验节点,实现问题的主动发现和实时告警,将损失扼杀在摇篮里。

四、系统对接的隐藏博弈论怎样导致成本失控?

最后我们来聊聊系统对接。这常常被看作是项目流程的最后一步,但其隐藏的成本博弈,往往是导致整个数据项目预算超支和延期的罪魁祸首。这里的博弈主要发生在数据团队和业务系统(如智能风控系统)团队之间。数据团队完成了漂亮的数据建模,产出了一系列精准的原子指标,希望通过API提供服务。但业务系统团队可能会因为自身系统的技术栈老旧、接口规范不统一、或者开发资源紧张等原因,要求数据团队进行大量的“适配”工作。这种来回拉扯,就是成本的空耗。

每一次“特殊适配”都意味着定制化开发,不仅增加了项目初期的开发成本,更可怕的是它埋下了长期的维护“技术债”。当未来原子指标或风控模型需要升级时,这些“补丁式”的接口会让迭代变得异常痛苦和昂贵。换个角度看,一个理想的指标体系设计,应该在立项之初就建立统一、标准化的服务契约。数据平台提供的原子指标服务应该是“即插即用”的,而不是“量体裁衣”的。这就要求企业在顶层设计上,就要有推动标准化的决心和权威。否则,数据中台的价值就会在无休止的系统对接博弈中被严重稀释,最终投入产出比远低于预期。构建一个成功的智能风控系统,不仅是模型和数据的胜利,更是组织协同和流程标准化的胜利。

【技术原理卡】

API版本控制的成本效益:在系统对接中,强制推行基于RESTful的API,并严格遵守版本控制(如 /api/v1/indicator, /api/v2/indicator)至关重要。V1版本可以保持稳定,服务于现有业务系统;新的原子指标或模型优化在V2版本中迭代。这避免了每次数据建模更新都可能破坏现有线上服务的风险,将沟通成本和返工成本降到最低。看似增加了少量的管理复杂度,实则为长期的系统演进提供了巨大的成本效益。

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。

.png)