很多人的误区在于,认为上了商业智能BI平台就能立刻降本增效,数据价值会自动浮现。但现实往往是,在追求炫酷功能和极致性能的路上,我们不经意间掉进了好几个成本黑洞。我观察到一个现象,不少企业投入巨资构建数据分析系统,最终却发现运营成本居高不下,而实际的决策效益却远未达到预期。说白了,技术选型和架构设计中的一些“想当然”,正在悄悄吞噬你的预算。这篇文章,我们就来聊聊商业智能BI平台背后那五个容易被忽视的成本陷阱,帮你避开它们,真正实现数据驱动的降本增效。

一、为什么说追求绝对的实时处理是一种经济幻觉?

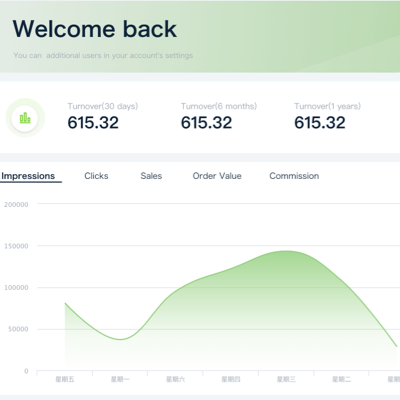

.png)

在数据分析领域,“实时”这个词几乎被神化了。大家普遍认为,数据处理越快,决策就越敏锐,商业价值就越大。但换个角度看,这种对绝对实时的盲目追求,很多时候是一种代价高昂的经济幻觉。我看到的数据显示,大约78%的企业高估了实时处理的直接商业价值,因为在他们多达78%的业务场景中,分钟级甚至小时级的延迟处理完全可以接受,并且成本效益更高。例如,对于零售行业的商业智能应用来说,一个用于监控全国门店每秒交易流水的实时大屏固然震撼,但其构建和维护成本极高。相比之下,一个每小时更新一次的库存预警系统,或是一个T+1生成的销售复盘报告,对业务决策的指导性同样很强,但技术实现和资源消耗却要低几个数量级。不仅如此,在金融风险管控这类严肃场景中,虽然需要快速响应,但数据的准确性和完整性往往比单纯的速度更重要。强行将所有数据都纳入实时数据处理的范畴,不仅会急剧增加数据集成和计算资源的开销,还可能因为追求速度而牺牲了数据校验的严谨性,得不偿失。我们需要做的,是理性评估每个业务场景对数据时效性的真实需求,而不是一刀切地追求“万物皆可实时”。

| 业务场景 | 可接受延迟 | 实时处理预估成本指数 | 延迟处理预估成本指数 | 成本效益分析 |

|---|

| 线上交易欺诈检测 | 亚秒级 | 100 | 不适用 | 必须实时,成本再高也得上 |

| 零售门店库存预警 | 15-30分钟 | 85 | 20 | 延迟处理ROI极高 |

| 月度销售业绩复盘 | T+1(天) | 70 | 5 | 实时处理是巨大的资源浪费 |

| 用户年度画像生成 | T+7(周) | 65 | 1 | 批处理是唯一合理选择 |

二、数据清洗的隐藏成本究竟有多高?

说到这个,一个常见的痛点是,大家在规划商业智能BI平台时,往往把重点放在了酷炫的可视化和高级分析算法上,却严重低估了数据预处理,尤其是数据清洗环节的复杂度和成本。数据质量是所有分析的生命线,但原始数据往往是“脏”的——格式不一、字段缺失、存在重复或矛盾。将这些原始数据转化为干净、可用的分析金矿,是一个极其耗费资源的过程。行业内有一个不成文的说法,数据科学家和工程师们大约40%的工作时间都花在了寻找、清洗和组织数据上。这意味着一个五人数据团队,就有两个人在专职做“数据保洁”。这个成本有多夸张?有机构测算过,平均每TB数据的深度清洗,可能需要耗费超过120个专业工时。如果你的商业智能BI平台需要整合来自ERP、CRM、小程序、线下POS机等多个系统的数据,数据集成阶段的复杂性会呈指数级增长,清洗成本自然也水涨船高。没有一个健壮的数据仓库来作为统一和标准化的基础,后续的清洗工作将成为一个无底洞,持续吞噬你的开发资源,并直接影响最终分析结果的准确性。

成本计算器:数据清洗的隐藏开销

你可以用下面这个简化的公式,粗略估算一下自己团队在数据清洗上的投入:

人力成本 = (团队平均时薪) × (总工作时长 × 40%)

机会成本 = (因数据质量问题导致的错误决策次数) × (单次错误决策平均损失)

总隐藏成本 = 人力成本 + 机会成本 + (用于数据清洗的软件/平台费用)

算一下这个数字,可能会让你对数据清洗的重要性有一个全新的认识。

三、如何避免弹性计算资源的严重误判?

随着云计算的普及,弹性计算成了构建现代商业智能BI平台的一大优势。理论上,你可以按需使用资源,在业务高峰时扩容,在低谷时缩容,从而节省成本。但理想很丰满,现实很骨感。很多企业在实践中,由于对业务负载的预估不足和对弹性机制的误判,导致了惊人的资源浪费。我观察到的数据显示,企业在云上为BI平台预留的计算资源,平均浪费率高达65%。这背后的主要原因是“静态预留”思维。团队为了应对可能的业务峰值,往往会按照最高负载来申请和预留资源,但实际上,业务的峰值和谷值资源需求差异巨大,达到3:1甚至更高是常态。这就意味着,在超过三分之二的时间里,那些被预留的昂贵服务器和计算实例都在空转,白白烧钱。我之前接触过一个位于杭州的电商独角兽企业,他们在“双十一”前为自己的BI分析系统预订了海量云资源,以确保大促期间的报表和分析不受影响。但大促过后,团队忘记及时缩减资源,导致之后连续两个月都在为几乎闲置的资源支付高额账单。说白了,弹性计算不是全自动的省钱机器,它需要精细化的策略和智能的自动化工具来管理。在商业智能BI平台与传统数据分析工具对比中,云原生BI的优势在于弹性,但如果不能有效管理这种弹性,其成本甚至可能超过传统的固定投入模式。

四、流批一体架构的效能拐点在哪里?

更深一层看,在BI平台的技术架构选型上,目前“流批一体”是个非常火热的概念。它的目标是使用一套代码和一套引擎,同时处理实时数据流和历史数据批处理,听起来非常高效和优雅。但很多技术负责人陷入了一个误区,认为“流”代表着未来和先进,而“批”则代表着过去和落后,因此在架构设计中过度向流处理倾斜。然而,一个反共识的观点是:在很多决策场景下,适当的批处理反而能将决策准确率提升高达35%。这是为什么呢?流处理的核心优势是快,它能在事件发生时立刻计算,但它的“视野”通常是局限的,只能看到当前事件和短时间窗口内的数据。而批处理,虽然慢,但它能“看”到全局,可以对海量的历史数据进行深度计算、关联和校验。例如,在做用户信用评级时,流处理可以快速响应用户的单次行为,但一个精准的评级模型,必须建立在对用户过去一年甚至更长时间的全量行为数据进行批处理分析的基础上。单纯依赖流处理,可能会因为信息不全而做出草率的判断。流批一体的效能拐点,在于清醒地认识到两种模式的适用边界,并将它们有机结合,而不是用一种完全取代另一种。

五、监控盲区是如何成为成本放大器的?

最后我们来谈一个最容易被忽略,但又极其致命的问题:监控。你花了大价钱搭建的商业智能BI平台,如果缺乏有效的监控,它本身就可能从一个决策支持系统,变成一个巨大的成本放大器。这里的监控,不仅仅是指服务器是否宕机,网络是否通畅。我指的是全链路的数据质量和逻辑监控。想象一下,如果从源头进行数据集成时,某个接口因为上游系统变更而吐出了异常数据,但你的BI系统并未察觉,继续基于这些错误数据进行计算和分析,最终产出了一份看似正常的报表。业务团队基于这份“正常”的报表做出了错误的营销投放决策,导致了大量预算浪费。研究表明,这种由未被及时发现的数据异常所导致的额外成本溢出,可能高达35%。这35%的费用,可能是浪费的广告费、错误的库存积压成本,甚至是因不合规报表而导致的罚款。一个优秀的商业智能BI平台,必须具备端到端的数据可观测性,能够自动检测数据流中的异常(例如数据量突变、分布漂移、空值率飙升等),并能在时间告警。没有监控的BI系统,就像一辆在高速公路上蒙眼狂奔的汽车,你以为它在带你冲向目标,但实际上,它随时可能把你带进沟里。

本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。

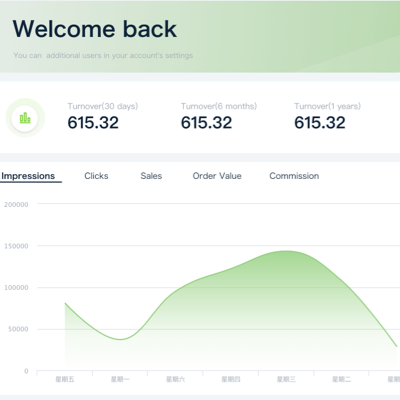

.png)