我观察到一个现象:许多企业在数据中心大屏项目上投入巨大,追求酷炫的3D动效和秒级刷新,仿佛大屏本身就是成果。然而,当冷静下来算一笔账时,会发现这些项目的投资回报率(ROI)往往低得惊人。一个常见的痛点是,我们花了上百万构建一个“指挥室”,最终它却沦为了一个昂贵的“访客展示品”。说白了,很多数据中心大屏的设计,从一开始就走偏了方向,重“展示”而轻“决策”。真正有价值的大屏,本质上是一个成本效益驱动的业务决策支持工具。它的每一项指标、每一次刷新,都应该能回答一个问题:这个数据能帮我省下多少钱,或者多赚多少钱?如果不能,那它可能就是在悄悄吞噬你的预算。

一、实时数据采集的决策转化率陷阱,成本效益何在?

说到数据中心大屏,很多人反应就是“实时”。这个词似乎自带光环,代表着技术先进性和掌控力。但从成本效益角度看,“实时”恰恰是最大的陷阱之一。为了实现毫秒级或秒级的数据采集与展示,企业需要投入高昂的成本,包括更高性能的服务器、更复杂的流处理架构(如Flink/Kafka)、以及持续的运维人力。问题是,如此高的投入,换来的决策转化率真的匹配吗?

.png)

换个角度看,我们必须引入一个概念:数据的“决策价值半衰期”。并非所有数据都需要秒级更新。例如,机房的PUE(电源使用效率)指标,它的变化是缓慢的,每分钟甚至每15分钟更新一次,完全足够支撑节能决策。但如果为了追求“实时感”,强行将其刷新率提升到每秒一次,那么99%的数据点都是冗余信息,而你却为此付出了100%的成本。这就是典型的低决策转化率,高成本投入。很多人的误区在于,把技术上的“能做到”等同于业务上的“应该做”。一个常见的数据中心大屏常见问题就是,堆砌了大量高频刷新的“无用”指标,导致系统不堪重负,决策者眼花缭乱,最终的成本效益极差。

更深一层看,我们需要评估的是“机会成本”。投入在非必要实时数据采集上的预算,本可以用来优化更有价值的业务模块,比如更精准的容量预测分析,或更智能的故障根因定位。这些优化带来的成本节约,可能远超所谓“实时监控”带来的虚幻掌控感。因此,在设计数据中心大屏指标时,必须先问自己:这个指标的实时性,能驱动一个多高价值的即时决策?如果答案是否定的,那就果断降级,选择成本更低的近实时或批处理方案。

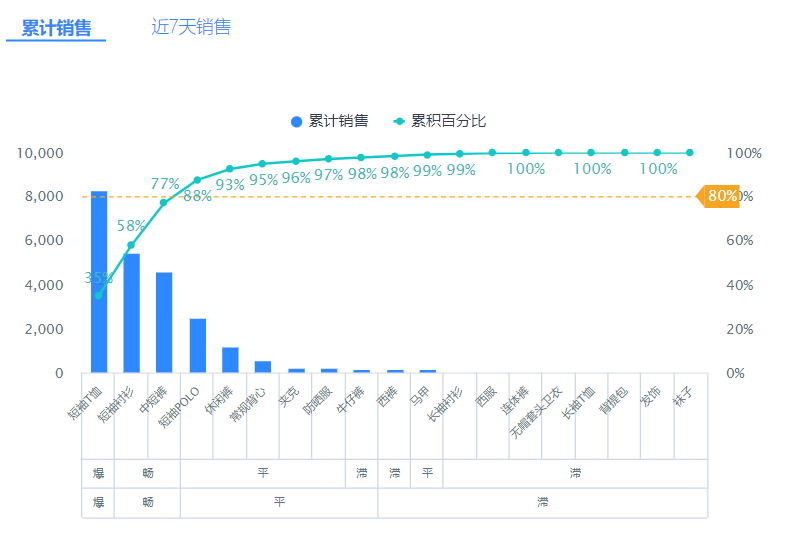

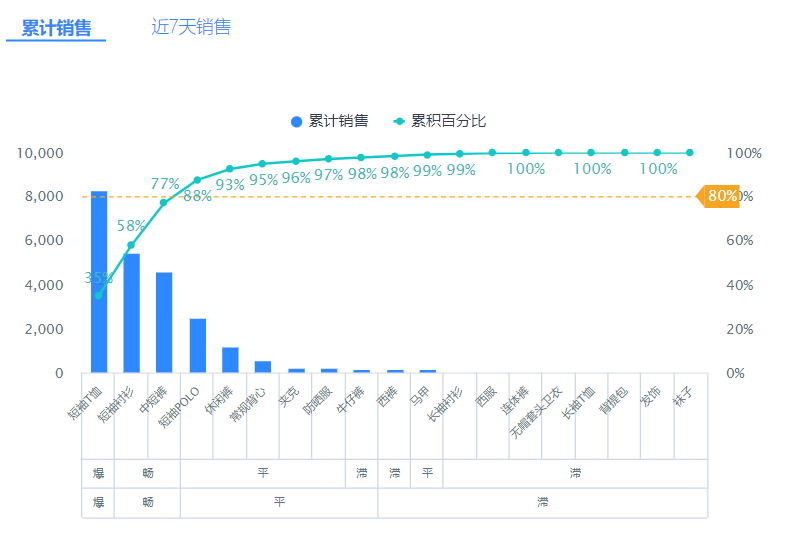

### 不同数据采集频率的成本效益对比

| 采集频率 | 数据处理技术栈 | 预估年化TCO(总拥有成本) | 典型适用场景 | 决策转化率评估 |

|---|

| 实时 (小于1秒) | Flink + Kafka + 高速TSDB | ¥800,000 - ¥1,500,000 | 在线交易欺诈检测、CDN节点调度 | 极高,决策价值以秒计算 |

| 近实时 (5-30秒) | Spark Streaming / Logstash + Elasticsearch | ¥300,000 - ¥600,000 | 应用性能监控(APM)、核心业务指标看板 | 较高,分钟级决策 |

| 批处理 (1分钟以上) | Hive / Spark SQL + 普通数据库 | ¥50,000 - ¥150,000 | 机房能耗分析、资源使用率报表、成本分摊 | 中等,小时或天级决策 |

---

二、如何破解可视化误区中的数据衰减定律?

谈完数据采集,我们再来看看数据可视化。一个残酷的现实是,绝大多数酷炫的图表,其信息价值都在随着时间的推移而快速衰减,这就是“数据衰减定律”在可视化领域的体现。但更糟糕的是,开发和维护这些复杂图表的成本,并不会衰减。这形成了一个可怕的成本黑洞。很多团队痴迷于实现3D机房漫游、粒子流动效果的拓扑图,这些功能在演示时非常惊艳,但在日常运维中,一个运维工程师需要花多久才能从这些花哨的动效中定位到一个具体的告警机柜?

说白了,这种设计的出发点就错了。它追求的是“视觉冲击力”,而不是“信息传递效率”。从成本效益的角度来看,一个优秀的可视化设计,应该遵循“最简路径”原则:用最短的时间、最少的视觉元素,把最重要的信息传递给决策者。一个简单的、带有明确阈值标识的折线图,其决策效率可能远高于一个需要旋转、缩放才能看清细节的3D模型。不仅如此,后者的开发成本、浏览器渲染开销和后期维护成本,可能是前者的数十倍。这就引出了一个在数据中心大屏设计中普遍存在的可视化误区:将技术复杂性等同于商业价值。

为了避免陷入这种高成本、低回报的困境,团队在规划任何一个新的可视化组件时,都应该先做一个简单的成本效益分析。这个分析不应该只停留在技术层面,而要直面商业价值。这个图表能帮助我们多快地发现问题?它能降低多少误判率?它能为我们的容量规划提供多精确的依据?这些问题的答案,最终都能被量化为节省的时间和金钱。如果一个可视化需求无法回答这些问题,那么它很可能就是一个“好看的负债”。

### 技术原理卡:可视化组件的成本效益计算器

在投入资源开发一个复杂的可视化组件前,不妨用下面的简易公式估算其潜在ROI。这能帮助团队做出更理性的决策。

年度开发与维护总成本 (A) = (前端开发人月 * 工程师月薪) + (后端开发人月 * 工程师月薪) + (年度服务器及软件许可费用)

年度可量化收益 (B) = (预估每日节省决策时间 * 决策者时薪 * 250工作日) + (预估降低的故障损失/年) + (预估提升的资源利用率节省成本/年)

年投资回报率 (ROI) = (B - A) / A * 100%

误区警示:如果一个组件的“年度可量化收益”难以计算,通常意味着它的业务价值本身就很模糊。这种情况下,选择最简单、成本最低的标准化图表(如折线图、柱状图)是更明智的选择。

---

三、智能告警系统存在哪些过度依赖的成本风险?

随着大数据分析和AI技术的发展,智能告警系统成了数据中心大屏的“标配”。它能基于算法自动发现异常,听起来非常美好。但很多人忽视了这种“智能”背后的巨大隐性成本——过度依赖带来的风险。一个常见的现象是,为了追求高召回率(不错过任何一个潜在问题),团队会将告警算法的灵敏度调得非常高。结果呢?告警风暴。运维团队每天被成百上千的“智能”告警淹没,其中90%以上都是无须立即处理的“噪音”或瞬时抖动。

这就是典型的“狼来了”效应,但它在企业里产生的却是实实在在的成本。每一次误报,都意味着一位高薪聘请的运维或开发工程师需要中断手头的工作,去排查一个本不存在的问题。这个过程涉及上下文切换、日志查询、跨团队沟通,时间成本非常高昂。我们可以算一笔账:假设一位工程师的时薪是300元,处理一次误报平均花费15分钟,那么单次误报的直接成本就是75元。如果一个系统每天产生100次误报,一天的无效成本就是7500元,一年下来就是两百多万。这笔钱,足以招聘好几位优秀的工程师了。因此,一个看似“智能”的告警系统,如果缺乏有效的成本控制和优化,很容易变成一个巨大的成本中心。

更深一层看,对智能告警的过度依赖,还会削弱团队自身的应急响应和问题判断能力。当所有人都习惯于等待系统发号施令时,主动巡检和基于经验的预判能力就会退化。一旦算法失灵或遇到未知场景(黑天鹅事件),整个团队可能会陷入被动,导致更长的故障恢复时间(MTTR),这带来的业务损失可能远超日常的运维成本。

### 案例分析:某独角兽电商的告警降噪实践

企业背景:一家位于深圳的快速发展中的电商独角兽公司。

初期痛点:引入了一套先进的AIOps智能告警系统,但由于配置激进,每日产生超过800个告警,真实有效的不足5%。三名SRE工程师几乎50%的工作时间都在处理这些告警工单,疲于奔命,核心的架构优化工作停滞不前。

优化措施:他们成立了专项小组,从成本效益角度重新审视告警策略。核心动作包括:1. 对告警进行分级,只有P0/P1级告警才触发实时电话/短信通知。2. 引入“告警收敛”机制,将同一根因的多个告警合并为一个。3. 提高低级别告警的触发阈值和持续时间要求,过滤掉大量瞬时抖动。

成果:经过两个月的优化,日均告警数从800+降至50左右,误报率从95%降低到40%以下。SRE团队花在无效告警上的时间减少了80%,能够重新聚焦于提升系统稳定性和成本优化上,间接为公司每年节省了超过百万的人力成本。

---

四、动态阈值算法的反向校准如何影响业务决策?

说到智能告警,就不能不提动态阈值算法。它能根据历史数据自动学习并调整告警基线,比僵化的静态阈值听起来要高级得多。但是,一个关键问题常常被技术人员忽略:这个“动态”调整的目标是什么?是尽可能捕捉所有异常,还是尽可能减少误报?在实际业务中,这两者往往是相互矛盾的。而如何在这两者之间取得平衡,恰恰是一个深刻影响成本效益的业务决策。

这里,我提出一个“反向校准”的思路。传统的做法是“正向配置”,即工程师根据技术经验设定算法参数,然后观察告警效果。而“反向校准”则是从最终的业务成本出发,倒推算法应该如何表现。具体来说,我们需要和业务方、财务方一起量化两个核心成本:

1. **C_fp (Cost of False Positive)**:即一次误报的成本。如我们前面计算的,它约等于处理一次误报所需的平均工时乘以工程师时薪。

2. **C_fn (Cost of False Negative)**:即一次漏报的成本。这个计算起来更复杂,通常是根据该指标异常可能导致的业务中断、用户流失、品牌声誉损失等进行估算。例如,交易成功率下跌未能及时发现,每分钟可能造成数万元的销售损失。

有了这两个成本数据,算法优化的目标就变得非常清晰了:**最小化总告警成本 (Total Cost of Alerting) = (每日误报数 * C_fp) + (每日漏报数 * C_fn)**。说白了,动态阈值算法的调优,本质上是一个数学优化问题,其目标函数就是业务总成本。例如,如果计算出C_fn是C_fp的100倍,那么算法在调优时就应该更倾向于“宁可错杀一千,不可放过一个”,即容忍更多的误报来避免漏报。反之,如果C_fn的成本远低于C_fp(例如一些非核心的内部系统),那么算法就应该更保守,以降低运维骚扰为主要目标。

这种基于成本效益的“反向校准”方法,将技术问题成功转化为了业务问题和管理问题。它促使技术团队不再闭门造车,而是主动与业务方对齐,共同为最终的商业结果负责。这样设计出来的数据中心大屏和告警系统,才真正从一个技术工具,进化为了驱动业务增长和成本优化的强大引擎。本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。

.png)