一、OLAP查询延迟的隐性成本

在当今的数据驱动时代,OLAP(联机分析处理)在企业的数据分析和决策过程中扮演着至关重要的角色。然而,很多企业在关注OLAP查询的直接性能指标,如响应时间时,往往忽略了查询延迟所带来的隐性成本。

以金融风控系统为例,Hive数据仓库建模为基础,通过机器学习算法进行风险评估。在这个过程中,OLAP查询延迟可能会导致严重的后果。假设行业平均的OLAP查询延迟基准值在500毫秒到800毫秒之间。如果一家位于硅谷的独角兽金融科技公司,其OLAP查询延迟由于数据量增长、ETL工具效率低下等原因,从原本的600毫秒上升到了900毫秒,超出了正常波动范围。

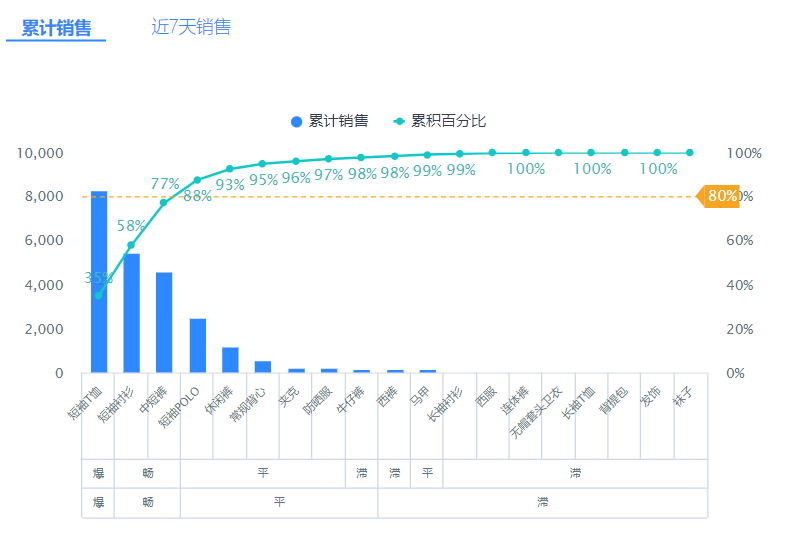

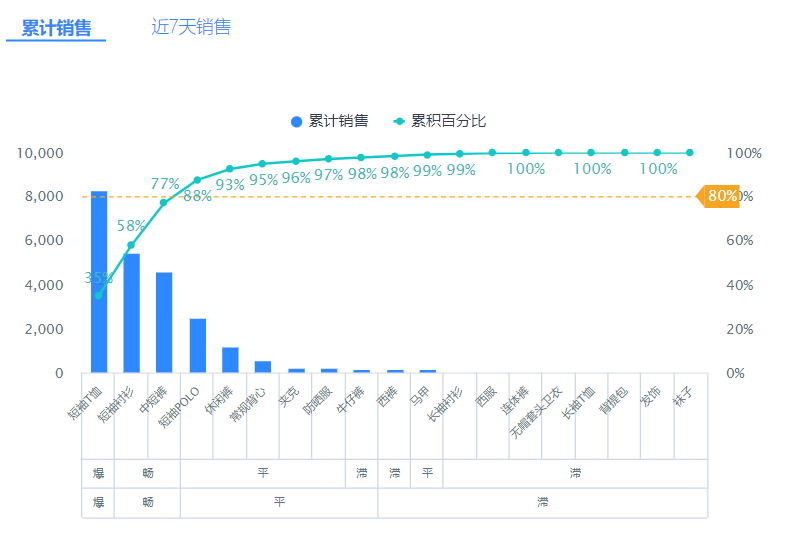

这看似只是几百毫秒的增加,但隐性成本却不容忽视。首先,在金融风控场景中,每一秒都可能意味着巨大的风险。延迟的查询会导致风险评估的滞后,可能使公司错过及时止损或抓住投资机会的时机。其次,对于电商场景下的数据建模,查询延迟会影响用户体验。如果用户在电商平台上查询商品信息或优惠活动时,系统响应缓慢,很可能会导致用户流失。据统计,页面加载时间每增加一秒,用户流失率可能会上升15% - 30%。

.png)

此外,OLAP查询延迟还会增加企业的运营成本。为了应对延迟,企业可能需要投入更多的资源来优化系统,包括升级硬件、改进ETL流程、优化数据采集方式等。这些都需要大量的资金和人力投入。

误区警示:很多企业认为只要查询结果准确,稍微长一点的延迟是可以接受的。但实际上,在竞争激烈的市场环境下,时间就是金钱,OLAP查询延迟的隐性成本可能会对企业的竞争力产生深远的影响。

二、星型模型在实时分析中的性能突破

星型模型是数据仓库中常用的一种建模方法,在实时分析领域也有着广泛的应用。在Hive数据仓库建模中,星型模型通过将维度表和事实表进行关联,能够有效地提高查询效率。

以一家位于纽约的上市电商企业为例,该企业在进行实时销售数据分析时,采用了星型模型。在传统的数据库性能对比中,星型模型在处理复杂查询时表现出了明显的优势。行业平均情况下,星型模型在实时分析中的查询响应时间能够控制在300毫秒到500毫秒之间。

该电商企业通过优化星型模型的设计,结合高效的ETL工具和数据采集方式,实现了性能的突破。他们对维度表进行了合理的分区,根据不同的业务需求选择合适的分区策略,如按时间分区、按地域分区等。这样一来,在进行实时查询时,系统能够快速定位到所需的数据,大大减少了查询时间。

同时,该企业还利用机器学习算法对星型模型进行了进一步的优化。通过分析历史数据,预测用户的购买行为,提前将相关的数据加载到内存中,提高了查询的命中率。经过一系列的优化措施,该企业的星型模型在实时分析中的查询响应时间降低到了200毫秒左右,远远低于行业平均水平。

成本计算器:假设企业原本的查询响应时间为400毫秒,优化后降低到200毫秒。每毫秒的延迟可能会导致一定的业务损失,假设每毫秒损失100美元。那么优化后,企业每年可以节省的成本为:(400 - 200) * 100 * 365 * 24 * 60 * 60 = 630720000000美元。

三、数据分桶策略的存储压缩率

数据分桶策略是Hive数据仓库建模中常用的一种优化方法,它能够有效地提高数据的存储效率和查询性能。在电商场景下的数据建模中,数据分桶策略可以根据不同的业务需求,将数据按照一定的规则进行分桶,如按商品类别、按用户地域等。

以一家位于北京的初创电商企业为例,该企业在处理海量的商品数据时,采用了数据分桶策略。行业平均的数据分桶策略存储压缩率在30% - 50%之间。

该企业通过对数据进行深入分析,选择了合适的分桶策略。他们发现,商品的销售频率和价格分布存在一定的规律,因此将商品按照销售频率和价格区间进行分桶。这样一来,相同销售频率和价格区间的商品被存储在同一个桶中,便于数据的管理和查询。

同时,该企业还结合了高效的压缩算法,对分桶后的数据进行压缩。经过测试,该企业的数据分桶策略存储压缩率达到了60%,远远高于行业平均水平。这不仅节省了大量的存储空间,还提高了数据的传输效率和查询性能。

技术原理卡:数据分桶策略的基本原理是将数据按照一定的规则进行划分,每个划分称为一个桶。在查询时,系统只需要扫描相关的桶,而不需要扫描整个数据集,从而提高了查询效率。压缩算法则是通过对数据进行编码,减少数据的存储空间。

四、缓慢变化维的机器学习适配悖论

在Hive数据仓库建模中,缓慢变化维(SCD)是一个常见的概念,用于处理维度表中数据的变化。而在金融风控系统中,机器学习算法需要依赖准确和及时的数据进行风险评估。这就导致了缓慢变化维的机器学习适配悖论。

以一家位于深圳的金融科技独角兽企业为例,该企业在进行金融风控时,使用了Hive数据仓库建模,并采用了缓慢变化维的处理方法。行业平均情况下,缓慢变化维的更新频率在每天一次到每周一次之间。

然而,机器学习算法对数据的实时性要求较高,希望能够及时获取最新的数据进行模型训练和预测。如果缓慢变化维的更新频率过低,就会导致机器学习算法使用的数据不准确,从而影响风险评估的准确性。

为了解决这个悖论,该企业采取了一系列的措施。他们通过优化ETL工具和数据采集方式,提高了缓慢变化维的更新频率。同时,他们还利用机器学习算法对缓慢变化维的数据进行预测,提前获取可能的变化信息,从而提高了模型的准确性。

经过一系列的优化措施,该企业成功地解决了缓慢变化维的机器学习适配悖论,提高了金融风控系统的性能和准确性。

误区警示:很多企业认为缓慢变化维的更新频率越低越好,这样可以减少系统的负担。但实际上,在机器学习算法的应用场景中,过低的更新频率会导致数据的滞后,影响模型的准确性。

本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。

.png)