这篇文章用咖啡馆聊天的口吻,带你从如何选择BI报表工具、为什么需要实时数据分析,到商业智能应用的落地,把报表制作的常见误区、数据清洗、可视化看板和指标拆解讲清楚。我们会给出行业平均数据的基准值、真实企业案例(上市/初创/独角兽)、以及流程与成本的技术原理卡与成本计算器,帮你避免决策跑偏。

文章目录

- 一、过度依赖自动化的认知陷阱:如何选择BI报表工具时不被“自动化”迷惑

- 二、数据源质量检测的致命漏洞:为什么需要实时数据分析做质量兜底

- 三、标准化流程缺失的蝴蝶效应:如何用BI报表统一数据清洗与指标拆解

- 四、人工干预必要性的逆势论证:为什么可视化看板仍要保留人工判断

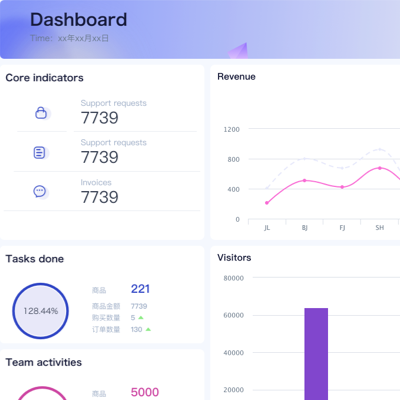

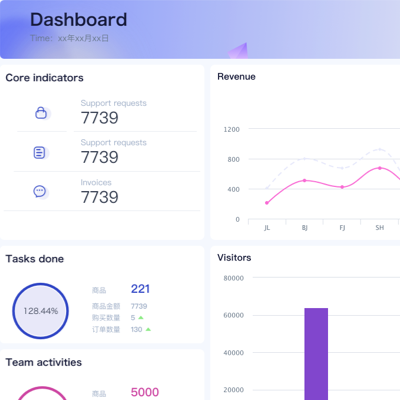

图片:BI报表工具选型流程图(占位,仅一次)

一、🔍过度依赖自动化的认知陷阱:如何选择BI报表工具时避免只看“自动化”?

聊选型,我常见到一个高频误区:只看“自动化程度”和“模板数量”,忽略数据清洗与指标拆解这两个硬骨头。BI报表不是越自动化越好,自动化只能缩短可视化看板的搭建时间,但如果底层数据源质量不稳,实时数据分析也会被“伪实时”坑到。如何选择BI报表工具,要先问三个问题:,是否支持源端数据质量检测(缺失值、重复值、合法性)?第二,是否具备指标拆解的元数据管理(口径定义、计算逻辑版本化)?第三,报表制作的常见误区能否被工具侧校验(比如私有口径混入公共指标、跨表连接未声明主键)?别被自动化漂亮包装迷惑,关键在数据清洗的稳定性与指标拆解的可复用。

.png)

作为一个做了十几年ToB的内容顾问,我更看流程:BI报表→数据分析技术→商业智能应用的链路要闭环。自动化只是“加速器”,不是“方向盘”。当你在可视化看板上点点点,实时数据分析看起来飞快,但若上游ETL时延不可控,或者报表制作的常见误区没被识别,每一次刷新都是把“错误”推送得更快。长尾词提示:BI报表工具选型指南;可视化看板设计规范;指标拆解方法论。

- 误区警示:把“自动填充字段”当成“指标口径一致”,把“智能图表推荐”当成“业务逻辑正确”,把“秒级刷新”当成“源数据可信”。

- 技术原理卡:自动化推荐背后多是简单的统计分布与图形映射,并非业务语义;指标拆解需要维度层级、口径模板和版本化管理,建议采用维表+度量仓库的结构。

成本计算器(口语版):你以为自动化能省3个人月,其实避不开1个人月的数据清洗和1个人月的指标拆解;若工具缺口径管理,后期对账每月都要多0.5个人月。长尾词提示:报表制作的常见误区清单;数据清洗最佳实践。

——————————

二、⚠️数据源质量检测的致命漏洞:为什么需要实时数据分析做数据质量兜底?

为什么需要实时数据分析?很多团队说为速度,其实更关键是拿“速度”校验“质量”。现实里,数据源错误往往来自埋点不一致、跨系统主键漂移、批处理窗口错位。没有实时质量监控,BI报表刷新越快,错误扩散就越快。我的建议是把实时数据分析作为质量兜底:在数据清洗阶段引入事件时序监控、重复与缺失检测、主维度稳定性预警;把可视化看板加上“质量视图”,让业务方看到数据可信度。长尾词提示:实时数据分析落地方法;商业智能应用案例。

为了让你有感觉,我放一张行业基准值对比表。说明:行业平均数据给出区间,企业样本相对平均值浮动±(15%-30%),选取技术热点地区(深圳/杭州/北京)。核心维度包括ETL时延、数据源错误率、仪表盘刷新间隔与KPI偏差率,帮助你直观看到实时与质量的耦合。

| 企业类型 | 地区 | ETL时延(分钟) | 数据源错误率 | 仪表盘刷新间隔(分钟) | KPI偏差率 |

|---|

| 行业平均数据(区间) | 全国 | 15–25 | 1.5%–2.5% | 10–20 | 3%–5% |

| 上市科技企业 | 深圳 | 18 | 2.1% | 12 | 3.8% |

| 初创SaaS | 杭州 | 12 | 1.3% | 8 | 2.5% |

| 独角兽云数据 | 北京 | 28 | 3.0% | 26 | 6.0% |

读表要点:ETL时延和仪表盘刷新间隔不是越短越好,前提是数据清洗口径稳定;错误率超过2.5%就要在BI报表的质量视图里拉红线;KPI偏差率高,先做指标拆解,别上来就调图表。长尾词提示:数据清洗最佳实践。

- 误区警示:忽视跨系统主键映射,导致报表制作的常见误区——同一用户在不同系统被重复计数;把实时数据分析当“秒级刷新”,忽略事件时序一致性。

——————————

三、🔄标准化流程缺失的蝴蝶效应:如何用BI报表标准化数据清洗与指标拆解?

没有标准化流程,BI报表就像拼乐高却少说明书:团队今天做数据清洗,明天做指标拆解,后天又把可视化看板重画一次。它的蝴蝶效应是:一次口径变更导致全站报表改版;一次埋点升级引起KPI历史不可比。标准化的核心是把BI报表→数据分析技术→商业智能应用串成SOP:数据清洗分层(ODS→DWD→DWS)、指标拆解模板(口径、维度、度量、版本)、可视化看板规范(图表映射、交互、刷新策略),再加上实时数据分析的质量闸。长尾词提示:指标拆解方法论;BI报表工具选型指南。

- 技术原理卡:用维度建模(星型/雪花)统一指标拆解;元数据服务管理报表口径;质量规则引擎在ETL侧执行,实时告警推送到看板。

- 成本计算器:一次全链路标准化项目,团队3–5人,8–12周;工具年费10–30万;若无标准化,维护成本每月0.5–1人月持续消耗。可视化看板设计规范是省钱点,别忽视。

实操建议:先建立“口径白名单”,把业务核心指标(GMV、订单、活跃)做指标拆解图谱;再按场景出一张可视化看板模版库;最后在BI报表里给出“数据清洗结果页”,把缺失、重复、合法性问题透明化。报表制作的常见误区是在图表里补逻辑,正确做法是在数据层修口径。长尾词提示:商业智能应用案例;数据清洗最佳实践。

——————————

四、✋人工干预必要性的逆势论证:为什么在实时数据分析与可视化看板里保留人?

听上去逆潮流,但我坚决主张在实时数据分析里保留“人”的位置。原因很现实:业务语义不是自动化能完全理解;新渠道上线、计费逻辑切换、促销口径变化,都会让BI报表的指标拆解与可视化看板需要人工研判。典型场景:上市IoT企业在上海上线新设备类型,主键组合改变;初创跨境电商在成都切换支付网关,订单状态新增“待风控”;独角兽工业互联网在南京引入新的采集频率。此时若无人工干预,报表制作的常见误区会扩大,比如把异常峰值当增长,或者把风控拦截当成交损失。长尾词提示:实时数据分析落地方法。

- 误区警示:把“异常检测”当“业务判断”,把“自动化修补”当“口径确认”。在数据清洗里,人要确认语义;在指标拆解里,人要确认口径;在可视化看板里,人要确认解读。

实践路径:设“人机共治”流程——实时数据分析先跑质量规则;告警进入数据值班群;BI报表口径变更需业务负责人审批;可视化看板加入“说明卡片”,标注口径与版本。这样做不是拖慢速度,而是提升可信速度。长尾词提示:BI报表工具选型指南;报表制作的常见误区清单。

——————————

本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。

.png)