我观察到一个现象:许多企业在数据驱动的道路上,投入了巨额的资金购买BI工具、搭建数据中台、扩充分析师团队,但最终决策效率和质量的提升,却远没有预期的那么高。说白了,大家都在谈论数据如何赋能业务,却很少有人去算一笔成本效益账。一个常见的痛点是,数据项目最终变成了一个昂贵的“成本中心”,而不是预想中的“利润中心”。这背后,隐藏着许多数据应用中的成本黑洞。我们今天不谈那些高深的技术,就从成本效益的角度,聊聊商业分析中那些让你花冤枉钱的常见误区,以及如何进行市场趋势分析,让数据驱动的决策真正物有所值。

一、数据可视化盲区的冰山效应:你为看不到的数据付了多少成本?

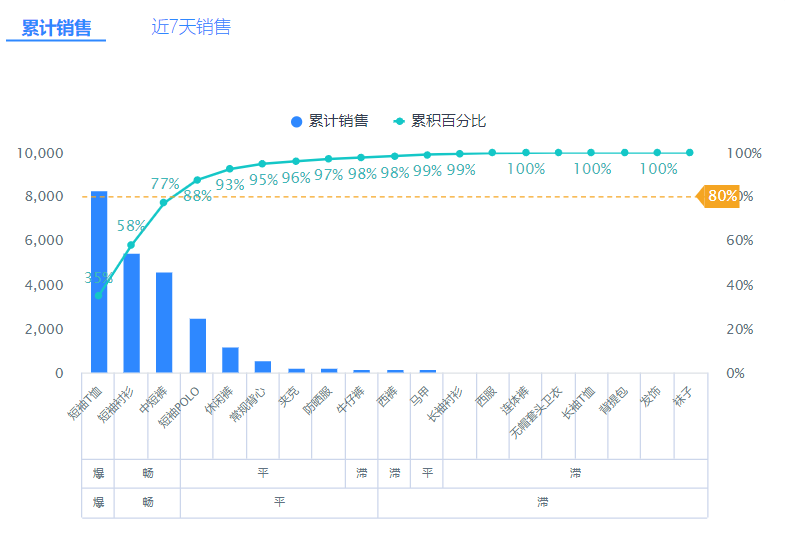

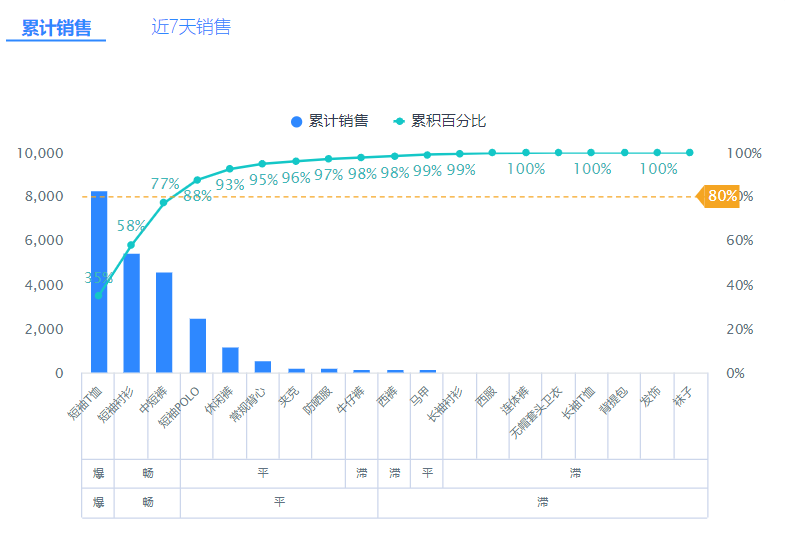

很多管理者认为,数据可视化就是把数据变成漂亮的图表。于是,大家热衷于打造酷炫的驾驶舱,屏幕上塞满了各种指标和动态图。但一个残酷的现实是,大部分可视化报表只展示了冰山一角,而隐藏在水下的巨大风险,正在悄悄吞噬你的利润。很多人的误区在于,把“看到数据”等同于“看懂数据”。一张设计糟糕的图表,不仅无法提供洞察,反而会形成误导,导致代价高昂的错误决策。比如,一个只显示总体销售额的曲线,可能会掩盖掉核心品类下滑、高利润产品滞销的严重问题。你为这张“看起来很美”的图表付出的成本,不仅是开发工具的钱,更是做出错误战略判断的机会成本。

更深一层看,数据可视化盲区的本质,是业务问题与数据呈现的脱节。分析师可能不完全理解业务痛点,只是机械地将数据字段拖拽到画布上;而业务人员又看不懂复杂的图表,只能凭感觉做决策。这种“两张皮”现象,使得整个经营参谋分析体系的投入产出比极低。企业为此付出的隐性成本是惊人的。我们不妨算一笔账:一个错误的库存决策,可能导致上百万的资金沉淀和仓储费用,而这一切的源头,可能仅仅是因为销售趋势图忽略了退货率这个关键指标。

### 成本计算器:可视化盲区导致的决策失误成本

| 评估维度 | 参数设定 | 成本估算 |

|---|

| 案例背景 | 某上市零售企业(深圳)误判季度促销效果 | - |

| 直接投入成本 | BI系统年费 + 2名数据分析师人力成本 | ¥800,000 |

| 误判导致的库存积压 | 错误备货2个SKU,总价值¥5,000,000 | ¥5,000,000 |

| 额外成本 | 仓储费、降价清仓损失(30%折扣) | ¥1,500,000 + ¥200,000 = ¥1,700,000 |

| 总计损失 | 直接投入 + 决策失误损失 | ¥7,500,000 |

说到这个,就不得不提一个真实的案例。华南一家知名的上市零售企业,为了实现精细化运营,上线了一套昂贵的商业智能(BI)系统。他们的销售仪表盘上,一条漂亮的增长曲线显示第三季度的总销售额环比上涨了25%。管理层据此判断市场需求旺盛,下达了追加20%库存的指令。然而,他们忽略了图表并未剥离“促销拉动”和“新品上市”的短期效应,更没有展示高毛利核心产品的实际销售趋势正在放缓。结果,第四季度市场回归平淡后,大量为“虚假繁荣”准备的库存变成了积压品,直接造成了近千万的损失。这就是典型的数据可视化盲区所带来的冰山效应,表面上风平浪静,水面下却撞上了巨大的成本冰山。

---

二、预测模型中的波动率陷阱:如何避免代价高昂的过度拟合?

进入预测分析和数据挖掘领域,成本的“坑”就更深了。很多技术团队痴迷于追求模型的准确率,比如一个用户流失预测模型,准确率从95%提升到98%,可能需要增加数倍的计算资源和数月的人工调优。从成本效益角度看,这种投入真的划算吗?一个常见的痛点是,大家为了在报告中展示一个亮眼的“99%准确率”,不惜一切代价去优化模型,结果却陷入了“波动率陷阱”。说白了,就是过度拟合(Overfitting)。一个在历史数据上表现完美的模型,很可能只是记住了过去的噪声和偶然波动,一旦遇到真实的市场环境变化,它的预测能力可能瞬间崩塌,造成比不用模型还大的损失。

换个角度看,模型的价值不在于它有多“准”,而在于它在不确定的未来中能提供多大的决策支持。一个85%准确率但鲁棒性极强的模型,其商业价值可能远超一个99%准确率但极其脆弱的模型。因为前者能帮你规避大的方向性错误,而后者可能会在关键时刻给你致命一击。企业在进行数据挖掘项目时,必须建立成本意识。这不仅包括服务器、软件的硬件成本,更包括顶尖数据科学家的机会成本,以及模型上线后因误判带来的业务风险成本。为什么需要数据驱动决策?是为了更科学地赚钱或省钱,而不是为了追求一个学术指标。

| 模型对比 | 模型A (鲁棒性优先) | 模型B (准确率优先) | 成本效益分析 |

|---|

| 准确率 | 88% | 98% | 模型B在测试集上表现更优 |

| 开发成本/月 | ¥50,000 (标准算力+中级工程师) | ¥250,000 (高性能算力+高级科学家) | 模型B成本是A的5倍 |

| 市场波动抗性 | 高 (能识别趋势,忽略小波动) | 低 (对历史数据中的噪声极其敏感) | 模型A更适应真实商业环境 |

| 黑天鹅事件损失 | 可控 (预测小幅偏离) | 巨大 (预测完全失效,导致错误资源配置) | 模型B的潜在风险成本极高 |

比如,北京一家SaaS初创公司,为了降低客户流失率,花重金组建团队开发了一套客户流失预测模型。团队耗时半年,终于将模型的AUC(评估指标)做到了0.98,在内部汇报时大放异彩。模型上线后,精准预测出了几十个“必然流失”的客户。然而,当一个主要竞品突然宣布降价50%时,大量模型判定为“安全”的客户开始集中流失,而模型对此毫无反应。原因就在于,模型过度学习了历史数据中“客户不活跃”、“工单增多”等特征,却没有考虑到市场突变这种从未在训练数据中出现过的宏观因素。公司为这个“高精度”模型付出的高昂开发成本,最终换来的是在关键战役中的惨败。

---

三、实时仪表盘的决策延迟:为何投入巨大却总是慢半拍?

“实时数据”是近几年特别火的概念。很多企业不惜投入重金,从Kafka到Flink再到ClickHouse,搭建一套复杂的实时数据链路,就是为了让CEO办公室大屏上的数字每秒一跳。但这里有一个巨大的成本效益问题被忽略了:你的决策流程,跟得上你的数据速度吗?我观察到一个普遍现象,许多公司拥有了秒级更新的实时仪表盘,但他们的运营会议依旧是每周一次,战略调整依旧是每季度一次。数据以光速传来,决策却依旧是牛车的速度。这中间巨大的延迟,让“实时”的价值大打折扣,而为之付出的高昂技术和维护成本,却一分钱都不能少。

说白了,这是一种技术上的“军备竞赛”,而不是业务上的实际需求。很多时候,T+1的日报、甚至T+7的周报,对于指导中长期决策已经绰绰有余。盲目追求实时性,就像给一个步行的人配了一台法拉利发动机,除了增加油耗(成本)和炫耀之外,没有任何实际意义。企业在规划企业决策支持系统时,应该先问自己一个问题:如果我能在1秒钟内知道某个指标的变化,我对应的响应动作是什么?如果这个动作的执行周期是1天,那么秒级数据的价值就几乎为零。这正是商业分析中常见的误区之一,错把技术先进性当成了商业价值本身。

### 误区警示:实时数据 ≠ 实时决策

- 误区表现:认为数据更新越快,决策就越敏捷、越准确。痴迷于构建“Real-time”数据架构。

- 背后真相:决策的瓶颈通常不在数据获取速度,而在人的认知、分析、讨论和执行流程。没有匹配的“实时行动力”,实时数据就是一种高成本的浪费。

- 成本陷阱:企业为零延迟的数据流支付了高昂的架构复杂性、计算资源和运维人力成本,但决策层和执行层仍然沿用传统的、非实时的议事和工作流程。

- 正确姿态:按需选择数据时效性。对于需要秒级响应的场景(如在线风控、实时竞价广告),实时是必要的;对于复盘分析、战略规划等场景,批处理数据成本更低、效果同样好。

一个典型的例子是一家位于杭州的物流独角兽企业。该公司为了提升其全国物流网络的调度效率,投资上千万打造了一个实时车辆追踪和订单监控系统。大屏幕上,成千上万个光点实时移动,数据流看起来非常震撼。然而,深入一线调研后发现,区域调度中心的主管们,仍然习惯在每天下班前,导出一份Excel报表,根据一整天的数据来规划第二天的车辆路线和人员安排。当被问及为何不利用实时数据进行动态调度时,他们的回答是:“信息变化太快,根本来不及反应。而且我们的人员和车辆都是按天排班的,中途调整的成本太高了。”最终,这个昂贵的实时系统,变成了一个仅供高层参观的“展览品”,其在企业决策支持中的实际效益微乎其微。

---

四、人工经验的反向修正价值:如何用低成本智慧校准昂贵的数据模型?

在数据驱动的浪潮下,我们似乎越来越迷信算法和模型,而忽视了人——尤其是那些拥有丰富行业经验的专家——的价值。这是一个巨大的成本效益误区。一个纯粹由数据驱动的决策系统,不仅开发和维护成本高昂,而且非常脆弱,容易被数据噪声、异常值或模型未曾学习过的“黑天鹅”事件所击垮。此时,引入人工经验进行“反向修正”,是一种成本极低、但回报极高的风险控制手段。

更深一层看,数据模型擅长在海量数据中发现相关性,但无法理解因果性。而一个资深的业务专家,他的大脑里装满了对业务因果链条的理解。比如,模型发现某个商品的点击率和转化率同步下降,可能会建议下架该商品。但一个经验丰富的品类经理可能会告诉你,这是因为上游供应商的原料出了问题,导致近期客诉增多,他只需要打个电话协调一下就能解决。这个“电话”的成本几乎为零,却避免了一次代价不菲的错误决策。因此,最好的企业决策支持系统,绝不是“去人化”的,而是将人的经验和智慧,与机器的计算能力高效结合的“人机协同”系统。

### 技术原理卡:人机协同(Human-in-the-loop)的成本效益

- 定义:在自动化决策流程中,于关键节点引入人工审核、判断或干预的机制。它不是自动化的对立面,而是其安全阀和增效器。

- 工作原理:模型可以处理95%的常规决策,并将5%的低置信度、高风险或异常的决策“标记”出来,交由人类专家进行最终裁定。

- 成本优势:极大降低了模型犯下灾难性错误的风险成本。与追求100%自动化而投入的无限开发成本相比,引入少量人工审核的综合成本(人力+技术)反而更低,系统整体的投资回报率(ROI)更高。

- 应用场景:金融领域的反欺诈审核、电商领域的重要商品调价、医疗领域的AI辅助诊断等。

换个角度看,人工经验不仅是“纠错器”,更是“导航仪”。在进行市场趋势分析时,数据可以告诉你“是什么”(What),但很难告诉你“为什么”(Why)以及“接下来该怎么办”(So What)。一位资深的市场总监,能结合数据趋势、竞争对手动态、宏观政策甚至社会文化变迁,给出一个比任何模型都更具前瞻性和可行性的战略判断。在商业智能系统中,与其投入巨资去训练一个试图理解“为什么”的复杂模型,不如建立一个高效的机制,让数据分析结果能够方便快捷地呈现给这些专家,让他们用低成本的智慧,去撬动高价数据背后的巨大价值。这才是数据驱动决策的精髓所在。本文编辑:帆帆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。