上一篇,我们给大家介绍了观远数据基于多年零售行业数据预测经验提炼而成的“AI预测引擎”功能。这种在观远智能分析平台上实现一键预测的方式对于一些入门级的数据预测分析场景来说不仅十分“友好”,而且还能产出相当精准的预测结果。

精彩回顾:AI特别企划(三):智能分析平台之「AI预测引擎」

那么,为什么在零售行业如此复杂的业态环境下,观远数据「AI预测引擎」只需简单操作,便能输出较高的准确度呢?这与我们一直坚信符合业务逻辑的数据预测一定是需要遵循其因果性,一定要坚持做可解释的AI预测不无关系。这一篇,我们就跟大家聊聊,为什么观远数据要坚持做遵循因果关系的可解释性AI预测?

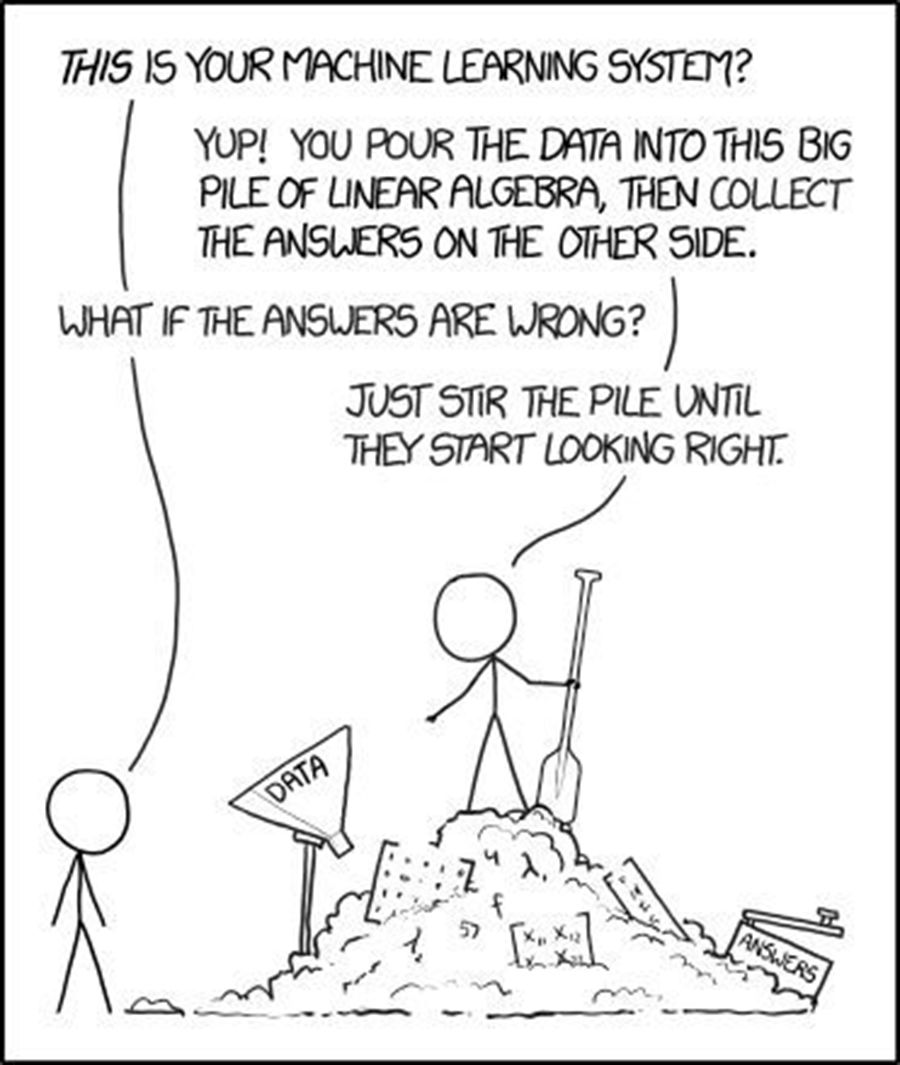

过去(包括现在),我们经常能在很多数据分析或BI产品上看到:在稀稀落落的散点图上,顺势一划,勾勒出一条曲线,再在横向时间轴上延展若干时间跨度,然后有人就告诉你——“喏!这就是你想要的预测!”。

这是一种典型的基于统计学方法的数据预测过程,通常使用线性拟合,高次曲线拟合等方法来做数据的预测。这类预测方法仅凭手头的数据,完全不需要考虑数据背后的业务逻辑。只要曲线阶次足够高,就可以做到历史数据拟合准确度无限逼近100%。

在曲线阶次限定(比如线性拟合)的情况下,这种预测由于方法简单,对预测结果还是具有一定的可解释性。但历史数据拟合的准确度不代表预测准确度,你很难说得清楚到底多少阶次的曲线拟合是更适合你的业务场景的。而且更严重的问题是,这种纯时间序列的趋势预测,只能单纯考虑时间的弱因果关系,根本没法考虑实际业务中因各种外部因素引起的数据变动,因此是一种不可增强的预测。

近年来,由机器学习和深度学习驱动的人工智能领域在发生着翻天覆地的变化。特别是深度学习,在各个领域都取得了骄人的成绩,比如人脸识别、语音识别、自然语言处理等领域的发展均深受影响。

而在预测分析方面,基于机器学习或深度学习的各类预测算法也在不断推动商业模式的变革。比如电商行业,基于大数据,根据客户点击与购买记录,利用算法推测客户喜好,展开精准营销。

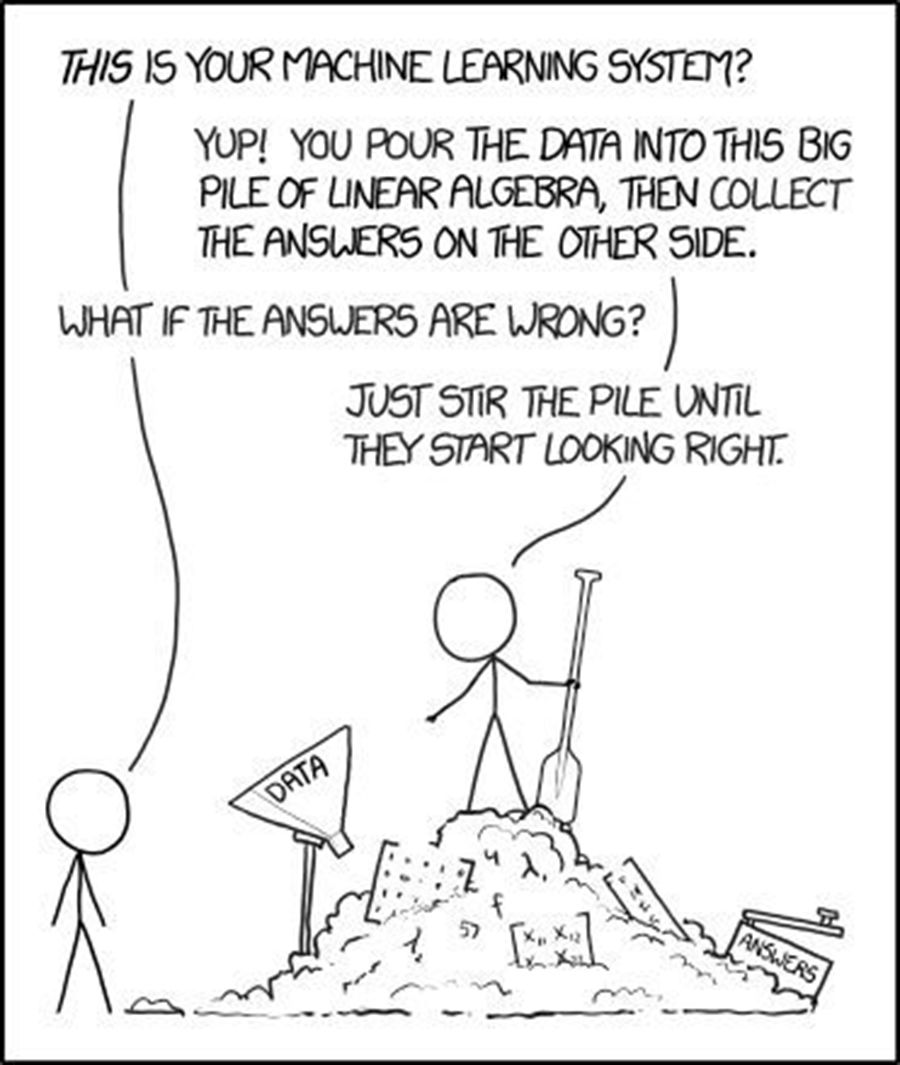

然而很多机器学习模型(深度学习首当其冲)的可解释性不强,这也导致在真正的商业应用中无法被广泛地采纳。这是因为企业决策者在做经营决策时无法接受一个不可解释的结论,更无法接受如果预测出来的结果并不准确,用户却不知道如何优化当前的模型。

图片来源:https://cloud.tencent.com/developer/article/1096716

那么这种不可解释的机器学习、深度学习方法为什么在某些场景下适用,而在预测场景内不适用了呢?

首先,我们来看几个深度学习适用的场景:人脸识别、自然语言处理。我们可以发现,这些场景都是基于可伸缩、高性能的基础设施,依赖于在大量数据集上训练得到复杂的机器学习分类模型,才有可能创建和使用我们并不真正理解的决策系统。

人们对于他们的信任,是基于大量的样本数据的训练和交叉检测,使得模型准确度达到可被广泛接受的程度。另一方面,在这些场景中,用户能提供的信息是全面的,无法再提供额外输入,比如,你不能让用户在进行人脸扫描的时候,再输入些其他信息来补充到算法模型里面。但以上两点,在真实的商业预测类场景里面却是不成立的:

1. 企业可以积累一定的历史数据来供预测算法使用,但绝非能够达到人脸识别、自然语言处理模型训练这样体量的样本数据量。

2. 企业业务数据的起伏波动往往是由各种外部因素共同作用引起的。我们在做预测分析的时候,不能仅仅局限于时序数据本身,而更应该深入分析业务场景,将各种具有因果关系的外部因素量化后加入到预测模型中来,这样的预测才是真正跟业务接轨的。而这种迭代优化的能力是人脸识别等场景所不具备的。

3. 企业数据在收集过程中,可能存在一些系统性的偏差,这可能会导致在预测、训练过程中找到一些虚假关联,做出错误决策,因此在做预测分析时,往往需要对结果的信任和接受作出解释。

鉴于以上原因,观远数据在做AI预测时,一直坚持算法模型遵循业务逻辑因果性,保证模型结果一定具有可解释的能力。只有这样,模型才能真正反映业务的内在逻辑,才能在预测结果不准时,主动去挖掘更多还未考虑进来的因子加入到预测模型中去,提升模型与业务的匹配度。

也只有这样,才有可能通过预测结果中的可解释因子来指导商业决策的选择与改进。而在预测模型准确度得到有效保障的基础上,因为构成模型的各个因素均具有可解释性,那么我们就可以将他们进行分类,用于进一步的分析与决策选择。

· 对于不可控的因素,企业一般无法改变,我们能做的是尽可能地去发现这些因素,并加到数据预测模型中来。

· 对于一些可控的因素,例如门店选址、新品研发、促销活动等,我们可以通过What-if分析与预测分析相结合的方式,来更好地指导决策。

由于业务场景千变万化,没有一套通用的预测算法可以解决所有问题。既然场景、模型都有那么多的选择,企业管理者对模型的信任都会比较谨慎。因此无论我们提供给客户的解决方案的最终目标是什么,客户都需要一个可解释、可关联、可理解的解决方案,这是建立信任的必要因素,因为它代表安全、责任与可靠!

此外,借助模型的可解释性,用户可以通过调整可控因素,获得最优预测结果,为企业管理者提供更多可操作的决策方法。而作为解决的提供商,我们也可以在模型的可解释性中受益,从而验证并持续改进我们的工作。

1. 判别并减少偏差

我们用来预测的数据集规模可能是有限的,并且不能代表所有数据,而且在数据收集过程中可能没有考虑到潜在的偏差。虽然数据偏差问题没有唯一的解决方案,但是可解释性一个关键的作用是可以帮我们意识到潜在的偏差。

2. 帮虑问题发生的上下文

在大多数时候,我们使用的数据集仅仅是正试图解决的问题的粗略表示,而机器学习模型无法捕捉到真实业务的完整复杂性。可解释模型可以帮助我们了解并解释模型中包含和未包含的因素,同时根据模型预测结果采取行动时,考虑该问题的上下文情境。

3. 改进预测模型的泛化能力与准确度

高解释性模型通常有更好的泛化能力。可解释性不是要数据的所有细节,但将可靠的数据,模型和问题理解结合起来往往获得准确度更好的解决方案。

4. 规避道德和法律风险

欧洲议会最近通过了通用数据保护法规(GDPR),该法规已于2018年5月成为法律。GDPR的一个创新方面是关于自动决策的条款,包括profiling,它首次在某种程度上为所有个人引入了一种解释权,以便在自动决策发生时对所涉及的逻辑进行有意义的解释。而在实际某些行业里,企业需要审计决策过程并确保它是没有歧视或违反任何法律。随着数据和隐私保护法规(如GDPR)的发展,可解释性变得更加重要。

综上,观远数据一直坚持做遵循因果性的可解释AI预测,既是对客户项目安全的负责,也是对项目落地的有效保证。观远数据「AI预测引擎」免费试用请点击文末 阅读原文。

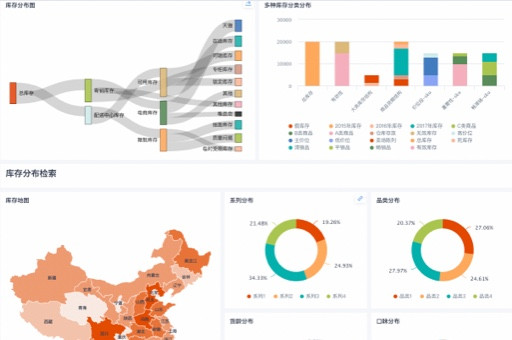

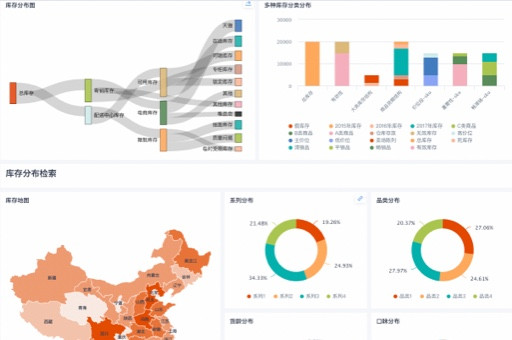

▲ 观远数据AI预测引擎使用界面示意图

AI特别企划篇结语

从AI的演进路径梳理、需求预测在AI+零售命题中的行业洞察,以及BI分析平台与AI预测如何有机结合,到今天的可解释AI预测——我们的AI预测企划也暂时要告一段落了,AI相关技术分享后续我们将在《观远AI实战》专题持续更新。感谢大家的关注,如果您有更多关于AI+BI方面的问题,欢迎联系我们一起探讨!观远数据将一直为您的企业经营决策数据分析保驾护航!