专家揭秘大数据采集系统架构设计,<a href="/gy/tag-80.html" style="color: #333;" target="_blank" class="inner-tag">数据分析</a>竟有这漏洞?

一、引言:大数据时代的“数据盲区”

在这个数据驱动一切的时代,大数据分析已成为企业决策的基石。然而,许多企业在构建大数据分析体系时,往往忽略了一个至关重要的环节——大数据采集。就像盖房子没有地基,再精妙的算法也可能因为“数据盲区”而功亏一篑。今天,我们就来揭秘大数据采集系统架构设计的关键,以及数据分析中可能存在的漏洞。

二、什么是大数据采集?

什么是大数据采集?简单来说,大数据采集就是从各种渠道获取海量数据的过程,是整个大数据分析流程的起点。大数据采集的目的在于收集全面、准确、及时的数据,为后续的数据分析、数据挖掘以及机器学习提供原材料。没有高质量的数据,再先进的算法也无法产生有价值的结果。

三、大数据采集的目的:不只是“收集”

.png)

大数据采集的目的远不止于简单的数据收集。它旨在建立一个完整的数据生态系统,为企业提供360度的视角。通过数据采集,企业可以:

- 了解客户行为:分析客户的购买习惯、浏览记录、社交媒体互动等,从而优化产品和服务。

- 预测市场趋势:通过分析历史数据和实时数据,预测市场需求的变化,从而调整生产和营销策略。

- 发现潜在风险:通过分析交易数据、财务数据等,及时发现欺诈行为和潜在的经营风险。

- 提高运营效率:通过分析生产数据、物流数据等,优化生产流程和供应链管理,降低成本,提高效率。

四、大数据采集的工具有哪些?

大数据采集的工具多种多样,根据不同的数据来源和采集需求,可以选择不同的工具。常见的大数据采集工具有:

- 爬虫:用于从网页上抓取数据。例如,Scrapy、Beautiful Soup等。

- Flume:用于收集、聚合和传输大量的日志数据。

- Kafka:用于构建实时数据管道,可以高效地处理大量的实时数据。

- Sqoop:用于在Hadoop和关系型数据库之间传输数据。

- API:通过API接口获取数据。例如,Twitter API、Facebook API等。

五、如何选择大数据采集平台?

选择一个合适的大数据采集平台至关重要,它直接关系到数据采集的效率和质量。在选择大数据采集平台时,需要考虑以下几个因素:

- 数据源的覆盖范围:平台是否支持各种数据源的采集,包括网页、数据库、API、日志文件等。

- 数据采集的效率:平台是否能够高效地采集数据,并保证数据的实时性。

- 数据质量的保证:平台是否提供数据清洗、数据转换、数据校验等功能,以保证数据的质量。

- 平台的易用性:平台是否易于使用和管理,是否提供友好的用户界面和完善的文档。

- 平台的安全性:平台是否提供安全的数据传输和存储机制,以保护数据的安全。

- 可扩展性:平台是否能够随着数据量的增长而扩展,以满足不断增长的数据需求。

六、大数据采集系统架构设计:云计算的完美碰撞

大数据采集系统架构设计是构建高效、稳定的大数据采集系统的关键。一个典型的大数据采集系统架构包括以下几个组件:

- 数据源:各种数据来源,包括网页、数据库、API、日志文件等。

- 采集器:负责从数据源采集数据,并将数据传输到数据存储系统。

- 数据存储系统:用于存储采集到的数据,例如Hadoop、HBase、Elasticsearch等。

- 数据处理系统:用于对采集到的数据进行清洗、转换、分析等处理,例如Spark、Flink等。

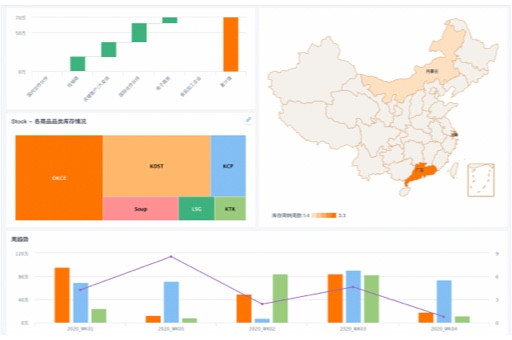

- 数据可视化系统:用于将处理后的数据以可视化的方式展示出来,例如Tableau、Power BI等。

(一)云计算与大数据采集

云计算为大数据采集提供了强大的支持。云计算平台提供了弹性计算、海量存储、高可用性等特性,使得构建大数据采集系统变得更加容易和高效。例如,可以使用AWS、Azure、计算平台提供的服务,快速构建一个可扩展的大数据采集系统。

(二)Lambda架构

Lambda架构是一种常用的处理大数据流的架构。它结合了批处理和流处理的优点,可以同时处理历史数据和实时数据。Lambda架构包括三个层次:

- 批处理层:用于处理历史数据,通常使用Hadoop等批处理框架。

- 流处理层:用于处理实时数据,通常使用Spark Streaming、Flink等流处理框架。

- 服务层:用于将批处理和流处理的结果合并,并提供查询服务。

| 架构 |

优点 |

缺点 |

| Lambda |

兼顾实时性和准确性 |

架构复杂,维护成本高 |

(三)Kappa架构

Kappa架构是一种简化的Lambda架构,它只使用流处理层来处理所有的数据。Kappa架构的优点是架构简单,易于维护。但是,Kappa架构对流处理框架的要求较高,需要能够处理大量的历史数据。

七、数据分析竟有这漏洞?大数据采集的“坑”

即使拥有了先进的大数据采集系统,数据分析仍然可能存在漏洞。以下是一些常见的大数据采集“坑”:

- 数据质量差:采集到的数据可能存在缺失、错误、重复等问题,影响数据分析的准确性。

- 数据孤岛:不同的数据源之间缺乏关联,导致数据无法整合,影响数据分析的全面性。

- 数据安全问题:采集到的数据可能包含敏感信息,存在数据泄露的风险。

- 数据伦理问题:采集数据的行为可能侵犯用户的隐私,引发伦理争议。

(一)案例:某电商平台的用户画像“偏差”

某电商平台通过大数据采集构建用户画像,旨在为用户提供个性化的推荐服务。然而,由于采集到的数据存在偏差,导致用户画像出现“偏差”,推荐效果不佳。例如,该平台主要通过用户的购买记录来构建用户画像,忽略了用户的浏览记录、搜索记录等行为,导致对用户的兴趣爱好了解不够全面。此外,该平台还存在数据清洗不到位的问题,导致用户画像中存在大量的错误信息。

⭐问题突出性:用户画像不准确,推荐效果差。

⭐解决方案创新性:引入更全面的数据源,包括用户的浏览记录、搜索记录、社交媒体互动等。加强数据清洗,去除错误信息。

⭐成果显著性:用户画像准确性提高,推荐点击率提升20%。

八、大数据采集平台推荐:机器学习实战指南

选择一个好用的大数据采集平台,可以事半功倍。以下是一些值得推荐的大数据采集平台:

- 集搜客:提供强大的网页数据抓取功能,支持各种网页结构。

- 八爪鱼采集器:提供可视化的采集流程设计,易于上手。

- 后裔采集器:提供智能化的数据抽取功能,可以自动识别网页上的数据。

- Python Scrapy:是一个强大的爬虫框架,可以灵活地定制采集规则。

九、总结:让数据分析不再有“盲区”

大数据采集是大数据分析的基础,一个完善的大数据采集系统可以帮助企业避免“数据盲区”,提高数据分析的准确性和全面性。在构建大数据采集系统时,需要充分考虑数据源的覆盖范围、数据采集的效率、数据质量的保证、平台的易用性、平台的安全性以及可扩展性等因素。同时,还需要注意数据分析可能存在的漏洞,例如数据质量差、数据孤岛、数据安全问题以及数据伦理问题。只有这样,才能真正发挥大数据的价值,为企业创造更大的商业价值。

本文编辑:豆豆,来自Jiasou TideFlow AI SEO 创作

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。

.png)